RISC-V 的开放性和可扩展性使其在 AI大模型部署 领域具有长期战略价值,尤其在国产化AI芯片、边缘计算、隐私计算 等方向可能成为关键突破口。不过作为一个诞生仅仅15年的新架构,RISC-V在大模型部署方面的经验和案例都远不如ARM和X86多,缺少比较成熟的案例。

7月18日,在第五届RISC-V中国峰会的人工智能分论坛上,阿里巴巴达摩院高级开发工程师徐鹏带来主题演讲《玄铁AI大模型部署优化实践》。

根据徐鹏介绍,截至2025年3月底,“魔搭社区”(阿里巴巴集团推出的开源AI模型社区)开源数量超过5.2万个,“千问模型家族”及其衍生模型数量超过10万家。不仅传统模型的数量庞大,大模型也在各行各业内涌现出了一些定制化的需求。与此同时,达摩院还在积极推动Vector和AME的推进。目前RISC-V社区当前的Vector已经ready,AME也在快速推进中。基于以上的业务需求和更新,对上层软件栈提出了更高的要求。

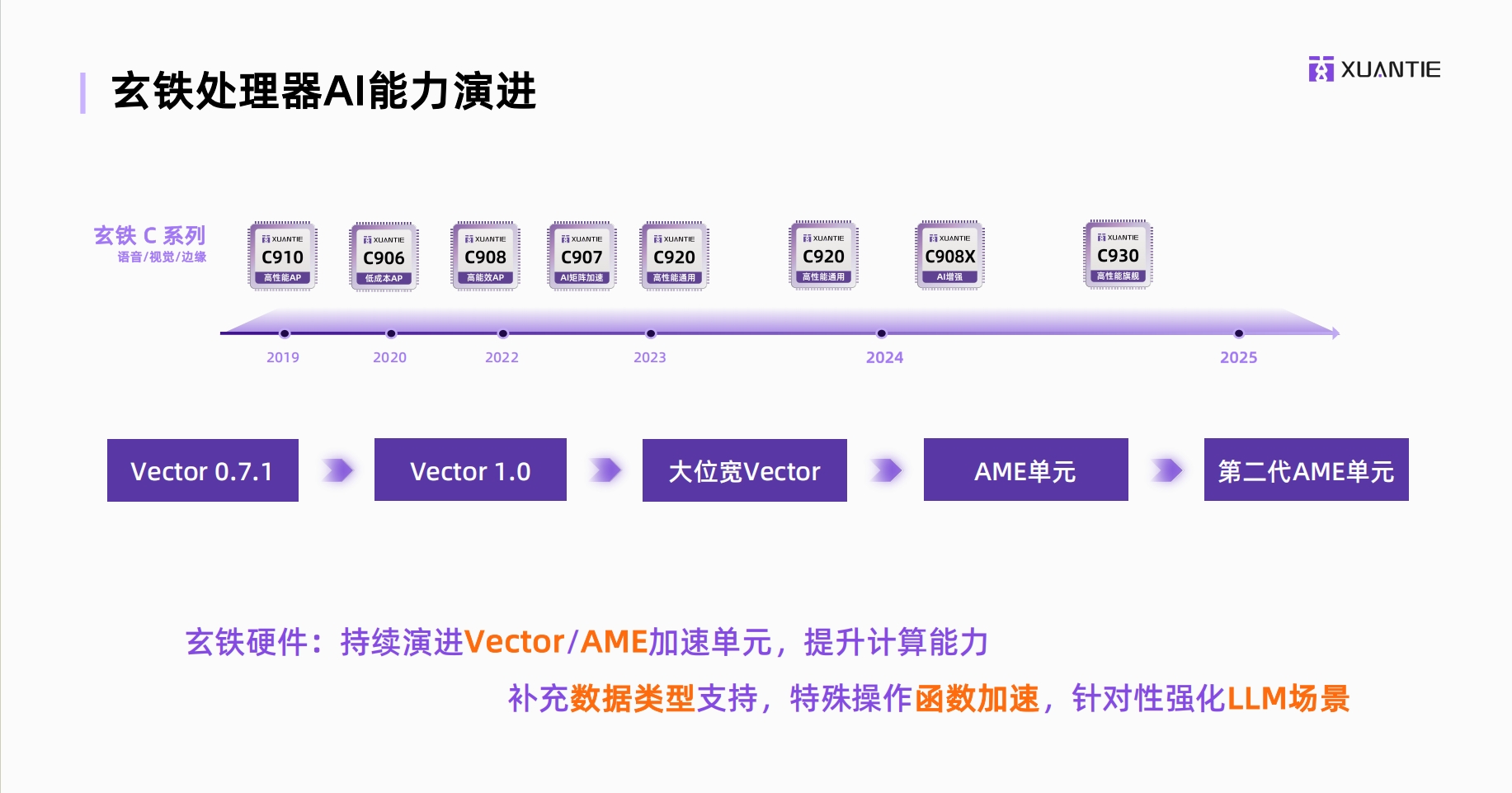

根据介绍,早在2019,达摩院便进行了Vector0.7.1,后续相继进行了Vector1.0、大位宽PyTorch、AME单元,而最近达摩院更新了第二代AME单元。玄铁硬件持续演进PyTorch和AME加速单元,提升计算能力,补充数据类型支持,特殊操作函数加速,针对性强化LLM场景。

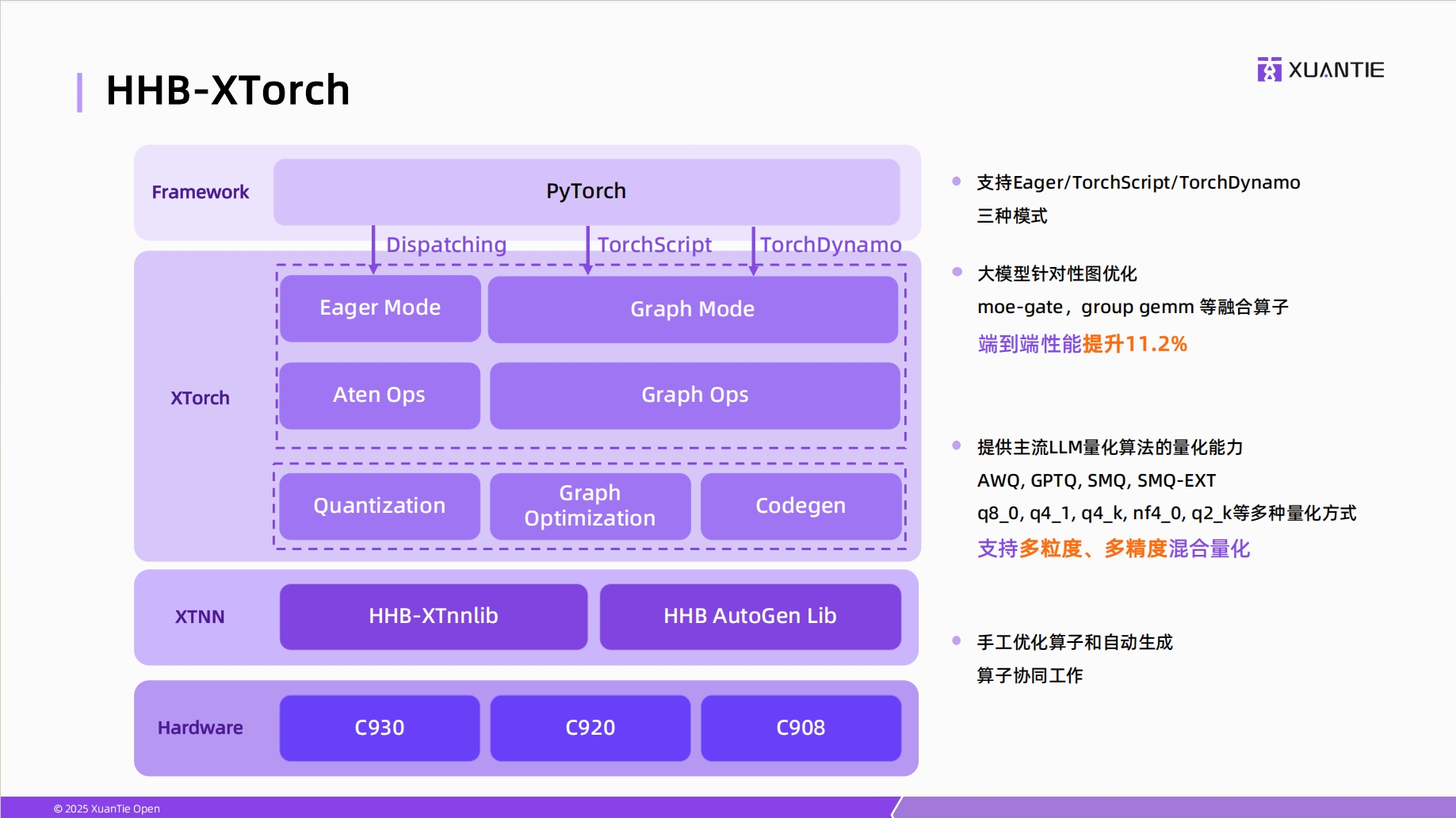

基于业务需求,玄铁构建了分层AI软件栈:底层为部署工具集HHB(含XTorch扩展组件),中层为PyTorch生态适配层,顶层为支持多精度量化的运行时引擎与算子库。这一架构实现了从模型训练到端侧部署的全链路覆盖。

PyTorch扩展是玄铁另一项重要工作。徐鹏表示,做好PyTorch的支持,一方面可以使用户能够无痛的切换到RISC-V硬件上。第二个方面可以复用PyTorch目前已经成熟的软件生态、拓展RISC-V的AI能力。具体到玄铁XTorch上,针对大模型、比如针对MoE模型提供系列算子融合、端到端性能提升了11.2%。同时在这个层次也方便用户部署,提供了大模型的良好能力的一些主流良好算法。例如:AWQ、GPTQ等,也提供q80等多粒度、多精度的量化能力支持。

根据介绍,玄铁NN库支持静态图和动态图的推理,支持目前大模型中需要用到的FP8、FP4等多数据类型、新数据类型的一些量化推理。在计算任务进入玄铁NN运行之后,系统会将整个计算任务拆分成一个一个的算子任务,然后再去单个核心上运算。同时,在进行大模型的推理过程之中,会将单个大模型计算任务去视为同一个计算流,然后通过整体的整个计算流的全局态的分析,最大程度的运行硬件的并行能力,通过One Graph推理方式端到端性能提升20.5%。底层会将Matrix和Vector抽象成流数据单元,一次性编排所有的计算任务和通信任务,相较于传统的执行方式能够更大的消减硬件的等待时间。

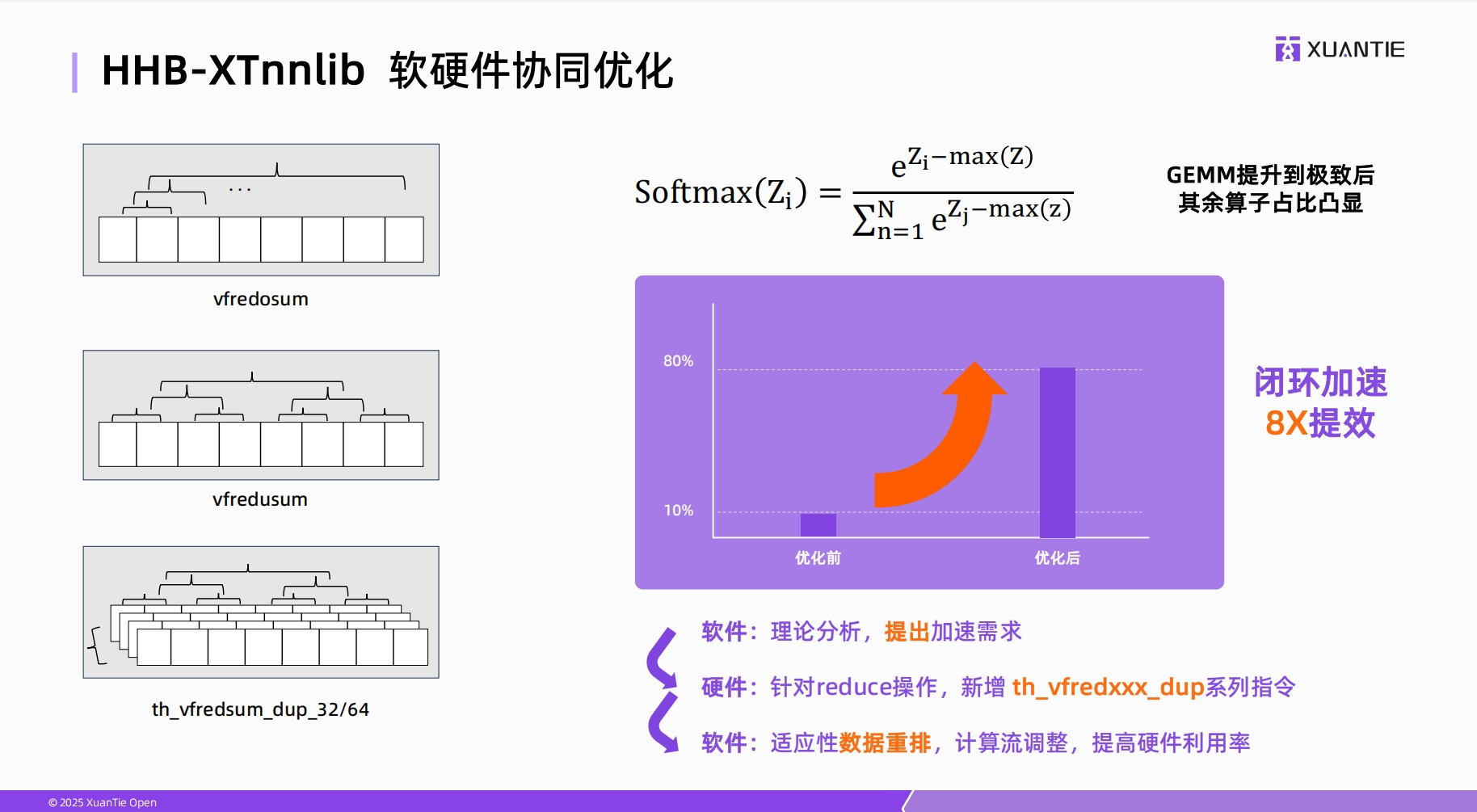

玄铁团队的优势是可以做软硬件协同优化,软件团队利用并行能力加速Softmax计算,硬件会根据需求分析、最终形成了reduce、dup系列指令,最终形成Softmax、通过闭环加速有了8倍提升。在Vector方面大模型用到的编码会使用到sigmoid/siln进行操作,玄铁硬件会专门的去做函数加速。例如sigmoid和silu算子的优化效果最终都有5倍的提升。针对GEMM加速效果也比较明显,fp16AME相较于竞品效率来说,提升了3倍左右。

在演讲最后,徐鹏透露玄铁团队正推进端侧推理优化及更高性能软件生态建设,例如支持LLaMA等主流模型的高效部署。他表示,玄铁将持续扩展生态系统,提供多精度混合量化、多线程调度算法等能力,推动RISC-V成为AI算力普惠化的核心载体。

发表评论 取消回复