2025年7月18日,第五届RISC-V中国峰会上继续进行,知合计算解决方案总监黄怡皓在人工智能分论坛上发表主题为《大模型在RISC-V架构上的技术创新与应用》的演讲。

2017年6月,Google 团队发表论文《Attention Is All You Need》,提出自注意力机制(Self-Attention),完全抛弃了传统的 RNN 和 CNN,用纯注意力机制处理序列数据。这使得 Transformer 高度并行化,极大程度上实现了人工智能训练速度的提升。2022年,ChatGPT横空出世,让人工智能成功摆脱“人工智障”的刻板印象,也让人工智能行业迎来一轮新的发展高潮。今年1月份DeepSeek的出现,则让大家对现在国产化及开源大模型的认知到达了一个新的高度。

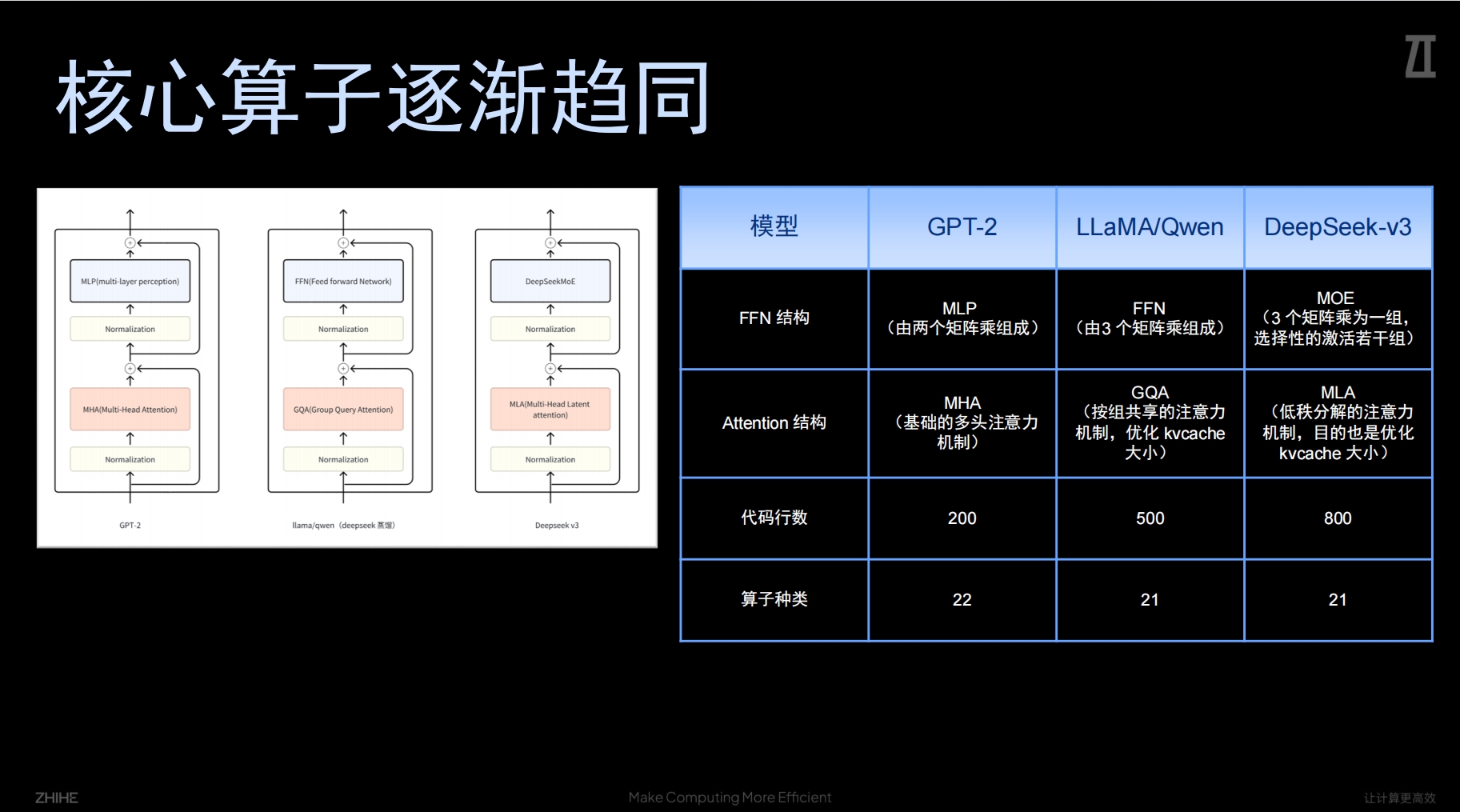

黄怡皓表示,尽管人工智能大模型的发展如火如荼,大模型在这些年的发展过程中经历了很多变化,但不论其技术如何调整,其底层架构依然是Transformer。虽然大模型呈现百花齐放的局面,但核心算子却一直呈现逐渐的趋同。

不论是GPT-2、通义千问还是DeepSeek R1模型,三家的模型架构都非常统一,这几个模型的变化都集中在具体的架构内部里面,而没有改变整个Transformer的结构,其算子基本上也在22个左右。除了算子的趋同之外,大模型的算力需求也非常集中。以DeepSeek 7B 模型为例,其核心算子共11个,Matmul 计算量占比约95%。

值得一提的是,随着人工智能底层技术的发展,目前AI在视觉方面,也从单纯的识别功能走向了更为高阶的认知功能。基于以往卷积算法,大模型能够实现的最直接效果便是识别,比如能够在一张图中比较精准地判断出人、动物、汽车,但是个体之间的联系其无法判断。若是基于Transformer,大模型在识别图片之时,可以判断不同物体之间的动作及相互之间的关系,比如图中所示的“熊猫吃竹子”的动作,第二张图是“植物上的昆虫”。

黄怡皓举了相应的案例,知合计算与一些客户做了一些在家庭场景的项目。如果是采用传统卷积算法,大模型想要判断视图中的小孩子在学习还是玩耍,中间会有比较复杂的流程,可能需要先识别人再识别手机、再识别手笔、然后是识别手臂与手机的相互位置关系,来实现判断。但现在基于Transformer算法的大模型,通过搜索“儿童玩手机”的指令,就可以非常快速、清楚地分辨。

目前,知合计算推出了首代通推一体CPU产品——A210,其支持Transformer架构。该产品算力达到12TOPS,采用自研Torq 架构,可实现算子抽象。通过自研Zmedia 架构,可实现多媒体抽象。黄怡皓在演讲时播放了基于A210平台做的AI智能体执行指令的视频,画面显示AI智能体可以实现比较流畅的点餐,即便指令在短时间会有多条指令,甚至出现指令覆盖的情况,仍可以非常顺利地完成执行。黄怡皓表示,“我们原来做过很多测试,从基础的“查询”到“替换”等之后、效果超过我们的预期。整个过程把前端的语音输入到中期数据处理,以及到后续的输出都做了一套完整的AI智能体。”不过,黄怡皓也坦言,作为端测芯片,A210更适合做一些标准化的细分场景的AI智能体。

随着人工智能的发展,目前通用计算和AI推理都需要更加高效。在算子趋同的背景下,原本在生态方面不如ARM的RISC-V意外与前者在同一起跑线上。另外,得益于开源的特点,开发团队对算子的优化将会更加直接和迅速。黄怡皓表示,“目前,AI能力已经开始慢慢从‘识别’走向了‘认知’,这个过程中我们如何将新的这些AI能力跟通用计算能力结合起来,是我们公司、也是我们接下来要去主要推进的方向。”

发表评论 取消回复